In seiner ersten Live-Keynote seit der Pandemie eröffnete NVIDIA-Gründer und CEO Jensen Huang heute die COMPUTEX-Konferenz in Taipeh und kündigte Plattformen an, mit denen Unternehmen auf einer historischen Welle generativer KI mitreiten können, die Branchen von der Werbung über die Fertigung bis hin zur Telekommunikation verändert.

Please accept YouTube cookies to play this video. By accepting you will be accessing content from YouTube, a service provided by an external third party.

If you accept this notice, your choice will be saved and the page will refresh.

„Wir sind zurück“, brüllte Huang, als er nach Jahren virtueller Keynotes, einige davon aus seiner heimischen Küche, die Bühne betrat. „Ich habe seit fast vier Jahren keine öffentliche Rede mehr gehalten – wünsche mir Glück!“

In seiner fast zweistündigen Rede vor rund 3.500 Teilnehmern beschrieb er beschleunigte Rechendienste, Software und Systeme, die neue Geschäftsmodelle ermöglichen und bestehende effizienter machen.

„Beschleunigtes Rechnen und KI markieren eine Neuerfindung der Datenverarbeitung“, sagte Huang, dessen Reisen in seiner Heimatstadt in der vergangenen Woche täglich von lokalen Medien verfolgt wurden.

Um seine Leistungsfähigkeit zu demonstrieren, nutzte er die riesige 8K-Wand, vor der er sprach, um eine Textaufforderung zu zeigen, die einen Titelsong für seine Keynote generierte, der wie jede Karaoke-Melodie singbar war. Huang, der gelegentlich in seiner Muttersprache Taiwanesisch mit der Menge plauderte, führte das Publikum kurz beim Singen der neuen Hymne an.

„Wir befinden uns jetzt am Wendepunkt eines neuen Computerzeitalters mit beschleunigtem Computing und KI, das von fast jedem Computer- und Cloud-Unternehmen auf der Welt angenommen wird“, sagte er und wies darauf hin, dass mittlerweile 40.000 große Unternehmen und 15.000 Start-ups NVIDIA-Technologien nutzen, davon 25 Allein im letzten Jahr wurde die CUDA-Software rund eine Million Mal heruntergeladen.

Eine neue Engine für Unternehmens-KI

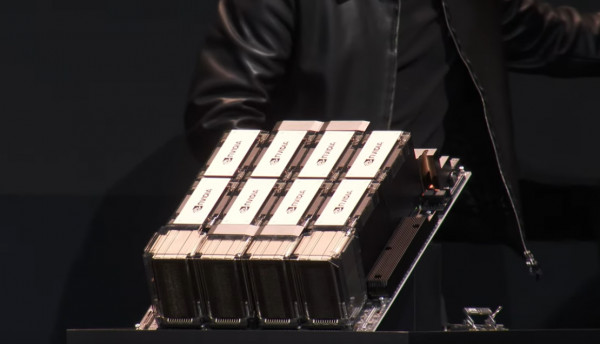

Für Unternehmen, die die ultimative KI-Leistung benötigen, stellte er DGX GH200 vor , einen KI-Supercomputer mit großem Speicher. Es nutzt NVIDIA NVLink , um bis zu 256 NVIDIA GH200 Grace Hopper Superchips in einer einzigen GPU in Rechenzentrumsgröße zu kombinieren.

Der GH200-Superchip, der laut Jensen jetzt in voller Produktion ist , kombiniert eine energieeffiziente NVIDIA Grace-CPU mit einer leistungsstarken NVIDIA H100 Tensor Core-GPU in einem Superchip.

Die DGX GH200 bietet eine Exaflop-Leistung und 144 Terabyte gemeinsam genutzten Speicher, fast 500-mal mehr als in einem einzelnen NVIDIA DGX A100 320-GB-System. Dadurch können Entwickler große Sprachmodelle für generative KI-Chatbots, komplexe Algorithmen für Empfehlungssysteme und grafische neuronale Netze erstellen , die zur Betrugserkennung und Datenanalyse verwendet werden.

Google Cloud, Meta und Microsoft gehören zu den ersten, die voraussichtlich Zugriff auf den DGX GH200 erhalten, der als Blaupause für die zukünftige hyperskalierte generative KI-Infrastruktur verwendet werden kann.

„DGX GH200 KI-Supercomputer integrieren die fortschrittlichsten beschleunigten Rechen- und Netzwerktechnologien von NVIDIA, um die Grenzen der KI zu erweitern“, sagte Huang dem Publikum in Taipeh, von dem viele stundenlang vor der Halle Schlange standen, bevor sich die Türen öffneten.

NVIDIA baut seinen eigenen riesigen KI-Supercomputer, NVIDIA Helios, der dieses Jahr online geht. Es werden vier DGX GH200-Systeme verwendet, die mit dem NVIDIA Quantum-2 InfiniBand- Netzwerk verbunden sind, um den Datendurchsatz für das Training großer KI-Modelle zu steigern.

Der DGX GH200 bildet das Spitzenmodell von Hunderten von Systemen, die auf der Veranstaltung angekündigt wurden. Gemeinsam bringen sie generative KI und beschleunigtes Computing für Millionen von Benutzern.

Mit Blick auf das Gesamtbild kündigte Huang an, dass mehr als 400 Systemkonfigurationen auf den Markt kommen, die auf den neuesten NVIDIA- Architekturen Hopper , Grace, Ada Lovelace und BlueField basieren. Ihr Ziel ist es, die komplexesten Herausforderungen in den Bereichen KI, Datenwissenschaft und Hochleistungsrechnen zu bewältigen.

Beschleunigung in jeder Größe

Um den Anforderungen von Rechenzentren jeder Größe gerecht zu werden, kündigte Huang NVIDIA MGX an , eine modulare Referenzarchitektur zur Erstellung beschleunigter Server. Systemhersteller können damit schnell und kostengünstig mehr als hundert verschiedene Serverkonfigurationen erstellen, die für eine breite Palette von KI-, HPC- und NVIDIA Omniverse- Anwendungen geeignet sind.

Mit MGX können Hersteller CPUs und beschleunigte Server mithilfe einer gemeinsamen Architektur und modularen Komponenten bauen. Es unterstützt NVIDIAs gesamte Palette an GPUs, CPUs, Datenverarbeitungseinheiten ( DPUs ) und Netzwerkadaptern sowie x86- und ARM-Prozessoren in einer Vielzahl luft- und flüssigkeitsgekühlter Gehäuse.

QCT und Supermicro werden die ersten sein, die im August MGX-Designs auf den Markt bringen. Das auf der COMPUTEX angekündigte ARS-221GL-NR-System von Supermicro wird die Grace-CPU verwenden, während das ebenfalls auf der Veranstaltung angekündigte S74G-2U-System von QCT Grace Hopper verwendet.

Auch ASRock Rack, ASUS, GIGABYTE und Pegatron werden MGX nutzen, um beschleunigte Computer der nächsten Generation zu entwickeln.

5G/6G erfordert Grace Hopper

Unabhängig davon sagte Huang, NVIDIA helfe dabei, die zukünftige drahtlose 5G- und 6G- und Videokommunikation zu gestalten. Eine Demo zeigte, wie KI auf Grace Hopper die heutigen 2D-Videoanrufe in lebensechtere 3D-Erlebnisse verwandelt und ein erstaunliches Gefühl der Präsenz vermittelt.

Um den Grundstein für neue Arten von Diensten zu legen, kündigte Huang an, dass NVIDIA mit dem Telekommunikationsgiganten SoftBank zusammenarbeitet, um ein verteiltes Netzwerk von Rechenzentren in Japan aufzubauen. Es wird 5G-Dienste und generative KI-Anwendungen auf einer gemeinsamen Cloud-Plattform bereitstellen.

Die Rechenzentren werden NVIDIA GH200 Superchips und NVIDIA BlueField-3 DPUs in modularen MGX-Systemen sowie NVIDIA Spectrum Ethernet-Switches verwenden , um das hochpräzise Timing zu liefern, das das 5G-Protokoll erfordert. Die Plattform wird die Kosten senken, indem sie die spektrale Effizienz erhöht und gleichzeitig den Energieverbrauch senkt.

Die Systeme werden SoftBank dabei helfen, 5G-Anwendungen in den Bereichen autonomes Fahren, KI-Fabriken, erweiterte und virtuelle Realität, Computer Vision und digitale Zwillinge zu erforschen. Zukünftige Einsatzmöglichkeiten könnten sogar 3D-Videokonferenzen und holografische Kommunikation umfassen.

Turbo für Cloud-Netzwerke

Unabhängig davon stellte Huang NVIDIA Spectrum-X vor , eine Netzwerkplattform, die speziell zur Verbesserung der Leistung und Effizienz von Ethernet-basierten KI-Clouds entwickelt wurde. Es kombiniert Spectrum-4-Ethernet-Switches mit BlueField-3-DPUs und Software, um eine 1,7-fache Steigerung der KI-Leistung und Energieeffizienz im Vergleich zu herkömmlichen Ethernet-Fabrics zu erzielen.

NVIDIA Spectrum-X- , Spectrum-4-Switches und BlueField-3-DPUs sind ab sofort von Systemherstellern wie Dell Technologies, Lenovo und Supermicro erhältlich.

Spielfiguren zum Leben erwecken

Generative KI beeinflusst auch, wie Menschen spielen.

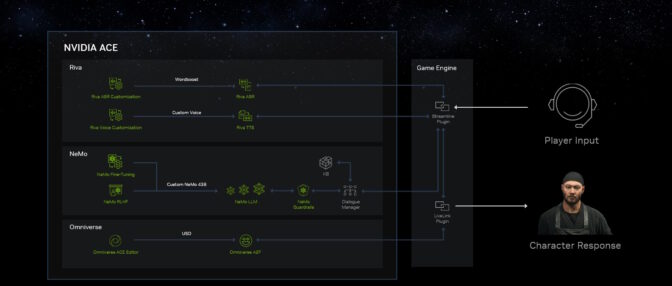

Huang kündigte die NVIDIA Avatar Cloud Engine (ACE) für Spiele an , einen Foundry-Service, mit dem Entwickler benutzerdefinierte KI-Modelle für Sprache, Konversation und Animation erstellen und bereitstellen können. Es vermittelt nicht spielbaren Charakteren Konversationsfähigkeiten, sodass sie auf Fragen mit lebensechten Persönlichkeiten antworten können, die sich weiterentwickeln.

NVIDIA ACE for Games umfasst KI- Grundlagenmodelle wie NVIDIA Riva , um die Sprache des Spielers zu erkennen und zu transkribieren. Der Text veranlasst NVIDIA NeMo, benutzerdefinierte Antworten zu generieren, die mit NVIDIA Omniverse Audio2Face animiert werden .

Beschleunigung der KI der Generation unter Windows

Huang beschrieb, wie NVIDIA und Microsoft zusammenarbeiten, um Innovationen für Windows-PCs im Zeitalter der generativen KI voranzutreiben .

Neue und verbesserte Tools, Frameworks und Treiber erleichtern PC-Entwicklern die Entwicklung und Bereitstellung von KI. Beispielsweise wird die Microsoft Olive-Toolchain zur Optimierung und Bereitstellung GPU-beschleunigter KI-Modelle und neuer Grafiktreiber die DirectML-Leistung auf Windows-PCs mit NVIDIA-GPUs steigern.

Durch die Zusammenarbeit wird eine installierte Basis von 100 Millionen PCs mit RTX-GPUs mit Tensor-Kernen verbessert und erweitert, die die Leistung von mehr als 400 KI-beschleunigten Windows-Apps und -Spielen steigern.

Digitalisierung der größten Industrien der Welt

Generative KI eröffnet auch neue Möglichkeiten in der 700 Milliarden US-Dollar schweren digitalen Werbebranche.

Beispielsweise arbeitet WPP, das weltweit größte Marketingdienstleistungsunternehmen, mit NVIDIA zusammen, um eine einzigartige generative KI-fähige Content-Engine auf der Omniverse Cloud zu entwickeln .

In einer Demo zeigte Huang, wie Kreativteams ihre 3D-Designtools wie Adobe Substance 3D verbinden, um digitale Zwillinge von Kundenprodukten in NVIDIA Omniverse zu erstellen. Mithilfe von Inhalten generativer KI-Tools, die auf verantwortungsvoll beschafften Daten trainiert und mit NVIDIA Picasso erstellt wurden , können sie dann schnell virtuelle Sets erstellen. WPP-Kunden können dann die komplette Szene nutzen, um eine Vielzahl von Anzeigen, Videos und 3D-Erlebnissen für globale Märkte und Benutzer zu generieren, die sie auf jedem Webgerät erleben können.

„Heute werden Anzeigen abgerufen, aber in Zukunft wird ein Großteil davon generiert, wenn Sie Informationen abrufen – das Computermodell hat sich geändert“, sagte Huang.

Fabriken schmieden eine KI-Zukunft

Mit geschätzten 10 Millionen Fabriken ist der 46 Billionen US-Dollar schwere Fertigungssektor ein fruchtbares Feld für die industrielle Digitalisierung.

„Die größten Industrien der Welt stellen physische Dinge her. Wenn wir sie zuerst digital aufbauen, können wir Milliarden einsparen“, sagte Huang.

Die Keynote zeigte, wie Elektronikhersteller wie Foxconn Industrial Internet, Innodisk, Pegatron, Quanta und Wistron digitale Arbeitsabläufe mit NVIDIA-Technologien gestalten, um die Vision einer vollständig digitalen Smart Factory zu verwirklichen.

Sie nutzen Omniverse und generative KI-APIs, um ihre Design- und Fertigungstools zu verbinden und so digitale Zwillinge von Fabriken zu erstellen. Darüber hinaus nutzen sie NVIDIA Isaac Sim zum Simulieren und Testen von Robotern und NVIDIA Metropolis , ein Vision-KI-Framework, für die automatisierte optische Inspektion.

Mit der neuesten Komponente, NVIDIA Metropolis for Factories , können maßgeschneiderte Qualitätskontrollsysteme erstellt werden, die Herstellern einen Wettbewerbsvorteil verschaffen. Es unterstützt Unternehmen bei der Entwicklung modernster KI-Anwendungen.

KI beschleunigt Montagelinien

Beispielsweise baut Pegatron – das weltweit 300 Produkte herstellt, darunter Laptops und Smartphones – mit Omniverse, Isaac Sim und Metropolis virtuelle Fabriken auf. Dadurch können Prozesse in einer simulierten Umgebung ausprobiert werden, was Zeit und Kosten spart.

Pegatron nutzte außerdem das NVIDIA DeepStream Software Development Kit, um intelligente Videoanwendungen zu entwickeln, die zu einer zehnfachen Verbesserung des Durchsatzes führten.

Foxconn Industrial Internet, ein Servicezweig des weltweit größten Technologieherstellers, arbeitet mit NVIDIA Metropolis-Partnern zusammen, um erhebliche Teile seiner Prüfpunkte für die Qualitätssicherung von Leiterplatten zu automatisieren.

In einem Video zeigte Huang, wie Techman Robot, eine Tochtergesellschaft von Quanta, NVIDIA Isaac Sim einsetzte, um die Inspektion an den Fertigungslinien des in Taiwan ansässigen Riesen zu optimieren. Im Wesentlichen geht es darum, simulierte Roboter zu verwenden, um Robotern beizubringen, wie man bessere Roboter baut.

Darüber hinaus kündigte Huang eine neue Plattform an, um die nächste Generation autonomer mobiler Roboterflotten (AMR) zu ermöglichen. Isaac AMR hilft bei der Simulation, Bereitstellung und Verwaltung von Flotten autonomer mobiler Roboter.

Ein großes Partner-Ökosystem – darunter ADLINK, Aetina, Deloitte, Quantiphi und Siemens – helfe dabei, all diese Fertigungslösungen auf den Markt zu bringen, sagte Huang.

Dies ist ein weiteres Beispiel dafür, wie NVIDIA Unternehmen dabei hilft, die Vorteile generativer KI durch beschleunigtes Computing zu nutzen.

„Es ist lange her, seit ich dich gesehen habe, also hatte ich dir viel zu erzählen“, sagte er nach dem zweistündigen Gespräch unter begeistertem Applaus.