Das Jahr 2025 markierte einen Durchbruch für die KI-Entwicklung auf dem PC.

Kleine Sprachmodelle (SLMs) für PCs haben ihre Genauigkeit bis 2024 um fast das Doppelte verbessert und den Abstand zu den fortschrittlichen, cloudbasierten großen Sprachmodellen (LLMs) deutlich verringert. KI-Entwicklertools für PCs wie Ollama, ComfyUI, llama.cpp und Unsloth sind ausgereift, ihre Popularität hat sich jährlich verdoppelt und die Anzahl der Nutzer, die PC-Modelle herunterladen, hat sich bis 2024 verzehnfacht.

Diese Entwicklungen ebnen den Weg dafür, dass generative KI in diesem Jahr bei alltäglichen PC-Nutzern, Gamern und Anwendern im Produktivitätsbereich weite Verbreitung finden wird.

NVIDIA kündigt diese Woche auf der CES eine Reihe von KI-Upgrades für GeForce RTX-, NVIDIA RTX PRO- und NVIDIA DGX Spark-Geräte an, die die Leistung und den Speicher freisetzen, die Entwickler benötigen, um generative KI auf dem PC einzusetzen, darunter:

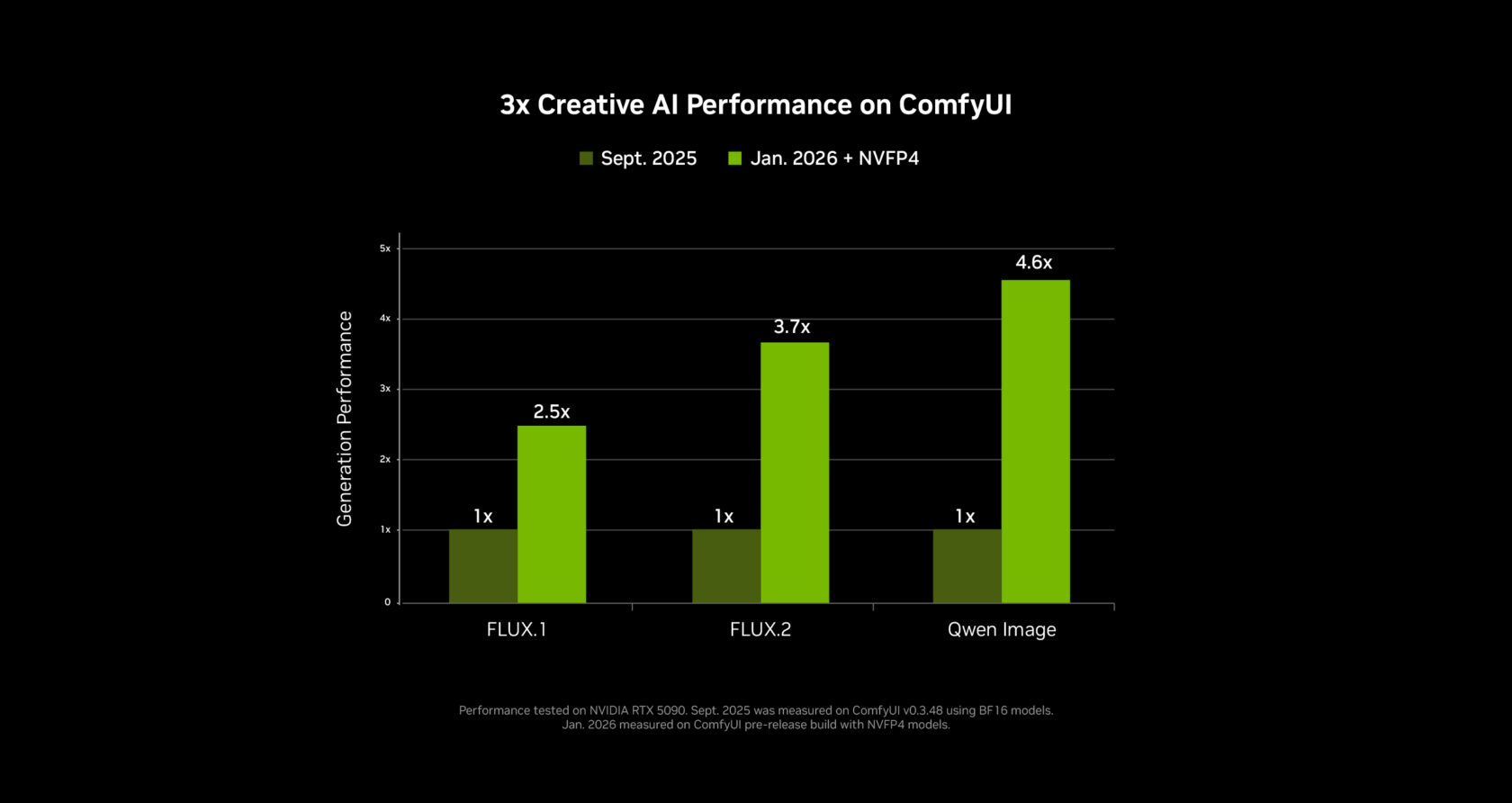

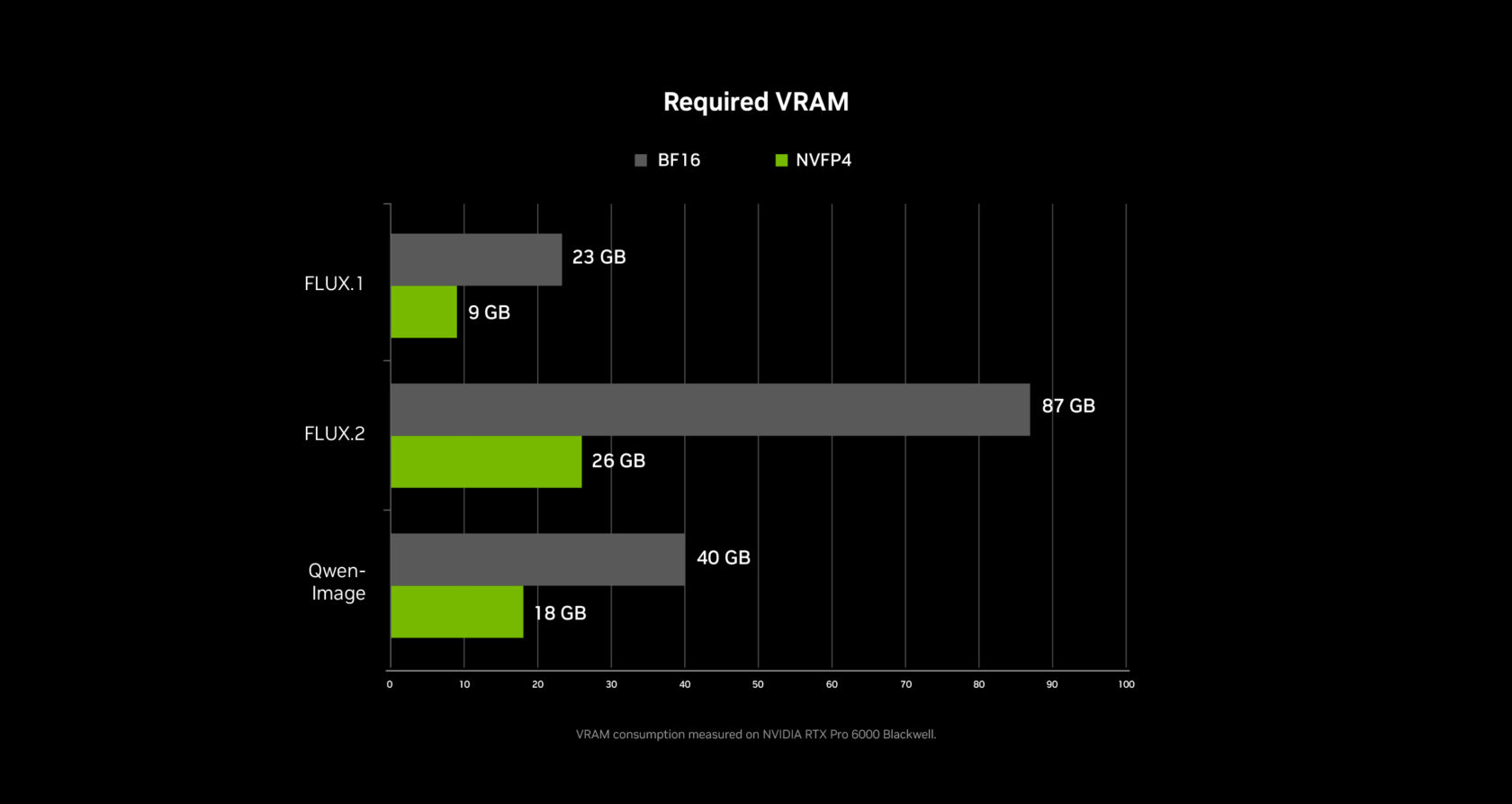

- Bis zu 3-fache Leistung und 60% Reduzierung des VRAM-Bedarfs für generative KI in Video und Bild durch PyTorch-CUDA-Optimierungen und native NVFP4/FP8-Präzisionsunterstützung in ComfyUI .

- Die Integration von RTX Video Super Resolution in ComfyUI beschleunigt die 4K-Videogenerierung.

- NVIDIA NVFP8-Optimierungen für die Open-Weights-Version des hochmodernen Audio-Video-Generierungsmodells LTX-2 von Lightricks .

- Eine neue Videogenerierungspipeline zur Erzeugung von 4K-KI-Videos unter Verwendung einer 3D-Szene in Blender zur präzisen Steuerung der Ausgaben.

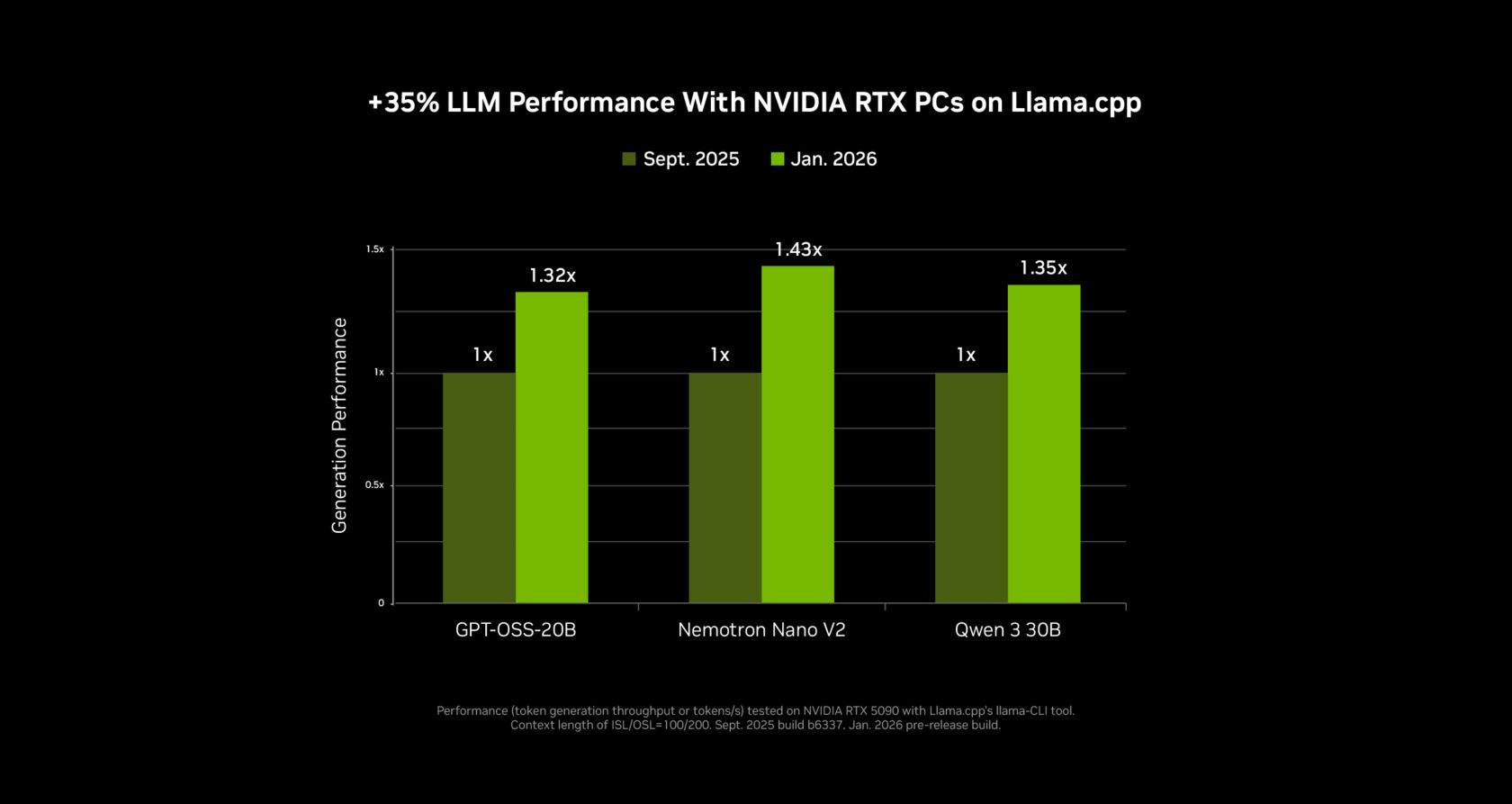

- Bis zu 35 % schnellere Inferenzleistung für SLMs durch Ollama und llama.cpp.

- RTX-Beschleunigung für die neue Videosuchfunktion Hyperlink von Nexa.ai.

Diese Fortschritte ermöglichen es den Nutzern, fortschrittliche KI-Workflows für Video, Bild und Sprache nahtlos mit der Privatsphäre, Sicherheit und geringen Latenz lokaler RTX-KI-PCs auszuführen.

Generieren Sie Videos 3x schneller und in 4K auf RTX-PCs

Generative KI kann beeindruckende Videos erstellen, doch Online-Tools lassen sich mit bloßen Eingabeaufforderungen oft nur schwer steuern. Die Generierung von 4K-Videos ist nahezu unmöglich, da die meisten Modelle zu groß für den Videospeicher (VRAM) eines PCs sind.

Heute stellt NVIDIA eine RTX-basierte Videogenerierungspipeline vor, die es Künstlern ermöglicht, die Generierung ihrer Videos präzise zu steuern und gleichzeitig Videos dreimal schneller zu generieren und auf 4K hochzuskalieren – und das mit nur einem Bruchteil des VRAM.

Diese Videopipeline ermöglicht es Nachwuchskünstlern, ein Storyboard zu erstellen, es in fotorealistische Keyframes umzuwandeln und diese Keyframes anschließend in ein hochwertiges 4K-Video zu verwandeln. Die Pipeline ist in drei Blaupausen unterteilt, die Künstler nach Belieben kombinieren oder an ihre Bedürfnisse anpassen können:

- Ein 3D-Objektgenerator, der Elemente für Szenen erstellt.

- Ein 3D-gestützter Bildgenerator, mit dem Benutzer ihre Szene in Blender einrichten und daraus fotorealistische Keyframes generieren können.

- Ein Videogenerator, der die vom Benutzer festgelegten Start- und End-Keyframes verwendet, um dessen Video zu animieren, und die NVIDIA RTX-Videotechnologie nutzt, um es auf 4K hochzuskalieren.

Diese Pipeline wird durch die bahnbrechende Veröffentlichung des neuen LTX-2-Modells von Lightricks ermöglicht, das ab heute zum Download bereitsteht.

LTX-2 markiert einen Meilenstein für die lokale KI-Videoproduktion und liefert Ergebnisse, die mit führenden Cloud-basierten Modellen mithalten können. Dabei generiert das System bis zu 20 Sekunden 4K-Video in beeindruckender Bildqualität. Es verfügt über integriertes Audio, Unterstützung für mehrere Keyframes und fortschrittliche Aufbereitungsfunktionen mit optimierter Low-Rank-Anpassung – für Filmschaffende kinoreife Qualität und volle Kontrolle ohne Cloud-Abhängigkeiten.

Im Hintergrund arbeitet ComfyUI an der Pipeline. NVIDIA hat in den letzten Monaten eng mit ComfyUI zusammengearbeitet, um die Leistung von NVIDIA-GPUs um 40 % zu optimieren. Das neueste Update bietet nun Unterstützung für die Datenformate NVFP4 und NVFP8. Insgesamt ergibt sich mit dem NVFP4-Format der RTX-50-Serie eine dreimal höhere Leistung bei 60 % weniger VRAM und mit NVFP8 eine doppelt so hohe Leistung bei 40 % weniger VRAM.

NVFP4- und NVFP8-Checkpoints sind jetzt für einige Topmodelle direkt in ComfyUI verfügbar. Zu diesen Modellen gehören der LTX-2 von Lightricks, FLUX.1 und FLUX.2 von Black Forest Labs sowie Qwen-Image und Z-Image von Alibaba. Sie können die Checkpoints direkt in ComfyUI herunterladen. Weitere Modelle werden in Kürze unterstützt.

Sobald ein Videoclip generiert wurde, wird er mithilfe des neuen RTX-Video-Knotens in ComfyUI innerhalb weniger Sekunden auf 4K hochskaliert. Dieser Upscaler arbeitet in Echtzeit, schärft Kanten und entfernt Kompressionsartefakte für ein klares Endbild. RTX Video ist ab dem nächsten Monat in ComfyUI verfügbar.

Um Nutzern zu helfen, die Grenzen des GPU-Speichers zu überwinden, hat NVIDIA in Zusammenarbeit mit ComfyUI die Speicherauslagerungsfunktion „Weight Streaming“ verbessert. Mit aktiviertem Weight Streaming kann ComfyUI den Systemspeicher nutzen, wenn der VRAM nicht ausreicht. Dadurch sind größere Modelle und komplexere mehrstufige Knotengraphen auf RTX-GPUs der Mittelklasse möglich.

Der Workflow zur Videogenerierung wird nächsten Monat zum Download bereitstehen, die neu veröffentlichten Open Weights des LTX-2 Videomodells und die ComfyUI RTX-Updates sind ab sofort verfügbar.

Eine neue Methode zum Durchsuchen von PC-Dateien und Videos

Die Dateisuche auf PCs hat sich seit Jahrzehnten nicht verändert. Sie basiert immer noch größtenteils auf Dateinamen und lückenhaften Metadaten, was die Suche nach einem bestimmten Dokument aus dem letzten Jahr unnötig erschwert.

Hyperlink – der lokale Suchagent von Nexa.ai – verwandelt RTX-PCs in eine durchsuchbare Wissensdatenbank, die Fragen in natürlicher Sprache mit eingebetteten Zitaten beantwortet. Dokumente, Präsentationen, PDFs und Bilder können gescannt und indexiert werden, sodass die Suche auf Ideen und Inhalten basiert, anstatt Dateinamen erraten zu müssen. Alle Daten werden lokal verarbeitet und verbleiben aus Datenschutz- und Sicherheitsgründen auf dem PC des Nutzers. Dank RTX-Beschleunigung benötigt Hyperlink nur 30 Sekunden pro Gigabyte für die Indexierung von Text- und Bilddateien und drei Sekunden für eine Antwort auf einer RTX 5090 GPU. Im Vergleich dazu dauert die Indexierung von Dateien auf herkömmlichen CPUs eine Stunde pro Gigabyte und 90 Sekunden für eine Antwort.

Auf der CES präsentiert Nexa.ai eine neue Beta-Version von Hyperlink mit Unterstützung für Videoinhalte. Nutzer können damit ihre Videos nach Objekten, Aktionen und gesprochenem Text durchsuchen. Das ist ideal für verschiedenste Anwendergruppen – von Videoproduzenten auf der Suche nach Rohmaterial bis hin zu Gamern, die ihren Sieg in einem Battle-Royale-Match mit Freunden teilen möchten.

Wer Interesse hat, die private Betaversion von Hyperlink zu testen, kann sich auf dieser Webseite anmelden. Der Zugang wird ab diesem Monat schrittweise freigeschaltet.

Kleine Sprachmodelle werden 35 % schneller

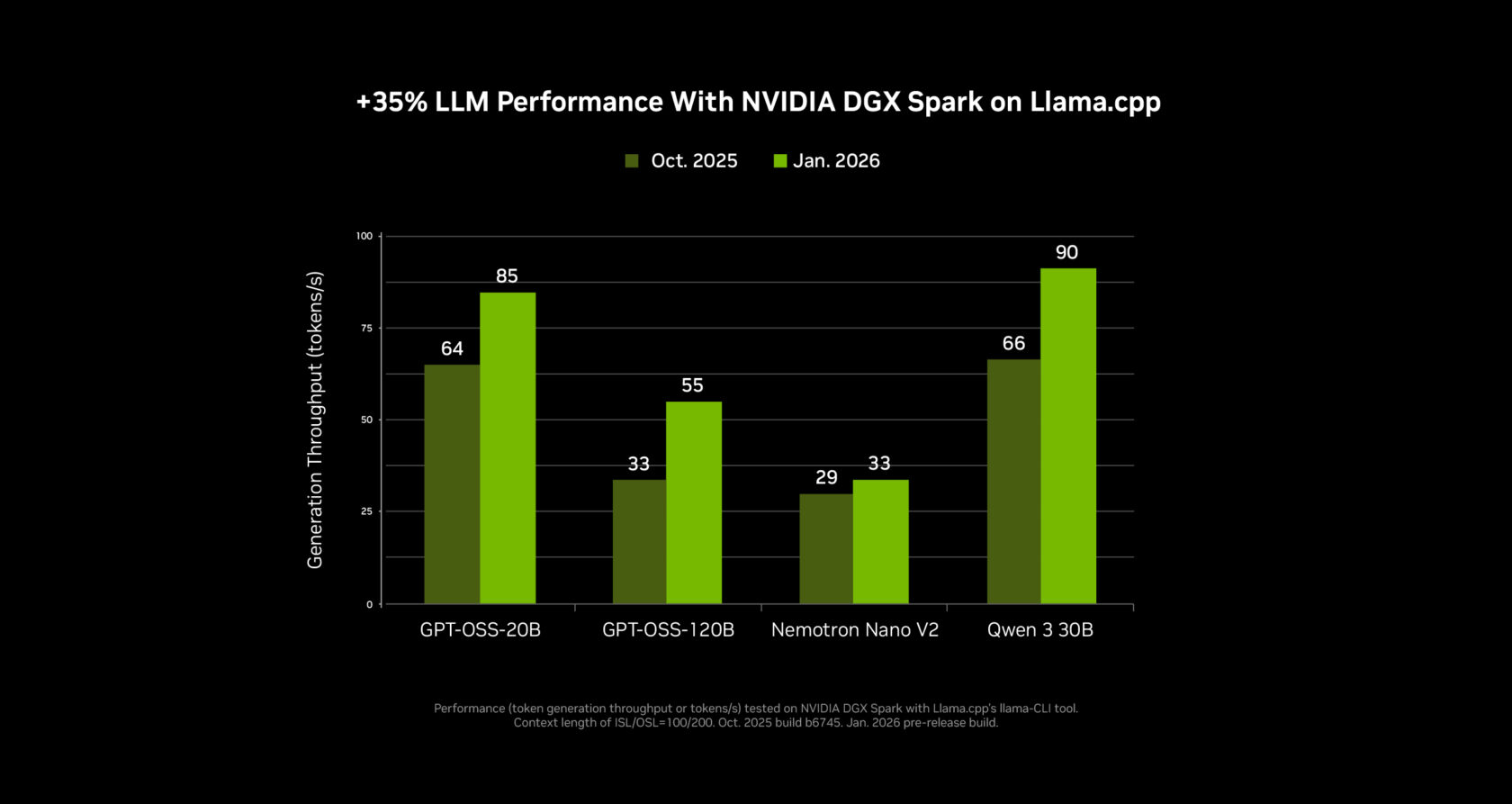

NVIDIA hat in Zusammenarbeit mit der Open-Source-Community mithilfe von Llama.cpp und Ollama deutliche Leistungssteigerungen für SLMs auf RTX-GPUs und dem NVIDIA DGX Spark Desktop-Supercomputer erzielt. Die jüngsten Änderungen sind besonders vorteilhaft für Mixture-of-Experts-Modelle, einschließlich der neuen NVIDIA Nemotron 3-Familie offener Modelle.

Die SLM-Inferenzleistung wurde in den letzten vier Monaten für llama.cpp und Ollama um 35 % bzw. 30 % verbessert. Diese Aktualisierungen sind ab sofort verfügbar, und ein Komfort-Upgrade für llama.cpp beschleunigt zudem die Ladezeiten von LLM.

Diese Geschwindigkeitsverbesserungen werden im nächsten Update von LM Studio verfügbar sein und in Kürze auch für agentenbasierte Anwendungen wie die neue MSI AI Robot App genutzt werden können. Die MSI AI Robot App, die ebenfalls die Optimierungen von Llama.cpp verwendet, ermöglicht Nutzern die Steuerung ihrer MSI-Geräteeinstellungen und wird die neuesten Updates in einer kommenden Version enthalten.

NVIDIA Broadcast 2.1 bringt die virtuelle Tastenbeleuchtung zu mehr PC-Nutzern

Die NVIDIA Broadcast-App verbessert die Qualität des PC-Mikrofons und der Webcam des Benutzers mithilfe von KI-Effekten und eignet sich ideal für Livestreaming und Videokonferenzen.

Version 2.1 optimiert den Virtual Key Light-Effekt und verbessert die Leistung. Er ist nun für Desktop-GPUs der RTX 3060 und höher verfügbar, unterstützt mehr Lichtverhältnisse, bietet eine erweiterte Farbtemperatursteuerung und verwendet eine aktualisierte HDRi-Basiskarte für den Zwei-Tasten-Beleuchtungsstil, der häufig in professionellen Streams zu sehen ist. Laden Sie das NVIDIA Broadcast-Update noch heute herunter.

Verwandeln Sie Ihr Heimstudio mit DGX Spark in ein KI-Kraftzentrum.

Da monatlich neue und immer leistungsfähigere KI-Modelle für PCs erscheinen, wächst das Interesse von Entwicklern an leistungsstärkeren und flexibleren lokalen KI-Umgebungen stetig. DGX Spark – ein kompakter KI-Supercomputer, der auf den Schreibtisch passt und sich nahtlos mit einem Desktop-PC oder Laptop verbinden lässt – ermöglicht das Experimentieren, Prototyping und Ausführen komplexer KI-Workloads parallel zu einem vorhandenen PC.

Spark eignet sich ideal für alle, die LLMs testen oder agentenbasierte Workflows prototypisch entwickeln möchten, oder für Künstler, die parallel zu ihrem Workflow Assets generieren möchten, damit ihr Haupt-PC weiterhin für die Bearbeitung zur Verfügung steht.

Auf der CES präsentiert NVIDIA bedeutende KI-Leistungsverbesserungen für Spark, die eine bis zu 2,6-mal schnellere Performance seit der Markteinführung vor knapp drei Monaten ermöglichen.

Es sind auch neue DGX Spark-Playbooks verfügbar, darunter eines für die spekulative Dekodierung und ein weiteres zur Feinabstimmung von Modellen mit zwei DGX Spark-Modulen.