SK hynix Inc. gab heute bekannt, dass es einen Kundenausstellungsstand auf der Venetian Expo eröffnen und seine KI-Speicherlösung der nächsten Generation auf der CES 2026 in Las Vegas vom 6. bis 9. Januar (Ortszeit) präsentieren wird.

Das Unternehmen erklärte: „Unter dem Motto ‚Innovative KI, nachhaltige Zukunft‘ planen wir, eine breite Palette von Speicherlösungen der nächsten Generation vorzustellen, die für KI optimiert sind, und werden eng mit unseren Kunden zusammenarbeiten, um im Zeitalter der KI neue Werte zu schaffen.“

SK hynix hat in der Vergangenheit sowohl einen Gemeinschaftsstand der SK Group als auch einen Kundenstand auf der CES betrieben. In diesem Jahr konzentriert sich das Unternehmen auf den Kundenstand, um den Kontakt zu wichtigen Kunden auszubauen und mögliche Kooperationen zu besprechen.

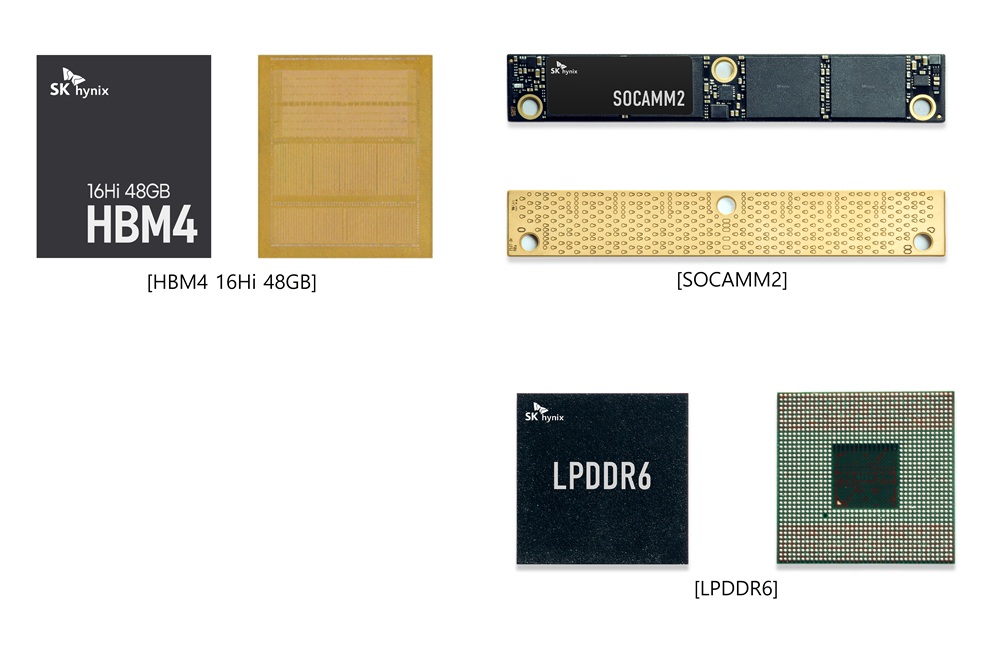

Das Unternehmen präsentiert auf der Messe erstmals ein 16-Layer-HBM4-Produkt mit 48 GB Speicher – die nächste Generation der HBM-Technologie. Dieses Produkt ist der Nachfolger des 12-Layer-HBM4-Produkts mit 36 GB Speicher, das mit 11,7 Gbit/s die branchenweit höchste Übertragungsgeschwindigkeit erreichte und sich in der Entwicklung befindet, abgestimmt auf die Kundenwünsche.

Ein 12-lagiges HBM3E-Produkt mit 36 GB, das den Markt in diesem Jahr prägen wird, wird ebenfalls vorgestellt. Insbesondere präsentiert das Unternehmen gemeinsam mit Kunden GPU-Module, die HBM3E für KI-Server nutzen, und demonstriert deren Einsatzmöglichkeiten in KI-Systemen.

Zusätzlich zu HBM plant das Unternehmen, SOCAMM2, ein stromsparendes Speichermodul speziell für KI-Server, vorzustellen, um die Wettbewerbsfähigkeit seines vielfältigen Produktportfolios angesichts der schnell wachsenden Nachfrage nach KI-Servern zu demonstrieren.

SK hynix präsentiert außerdem sein Angebot an konventionellen Speicherprodukten, die für KI optimiert sind, und demonstriert damit seine Technologieführerschaft im Markt. Das Unternehmen stellt seinen LPDDR6-Speicher vor, der für On-Device-KI optimiert ist und im Vergleich zu Vorgängergenerationen eine deutlich verbesserte Datenverarbeitungsgeschwindigkeit und Energieeffizienz bietet.

Im Bereich NAND-Flash präsentiert das Unternehmen sein 321-lagiges 2-TB-QLC-Produkt, optimiert für eSSDs mit extrem hoher Kapazität, um der steigenden Nachfrage aufgrund des rasanten Wachstums von KI-Rechenzentren gerecht zu werden. Dank branchenführender Integration bietet dieses Produkt im Vergleich zu QLC-Produkten der vorherigen Generation eine deutlich verbesserte Energieeffizienz und Leistung und ist daher besonders vorteilhaft in KI-Rechenzentrumsumgebungen, in denen ein geringer Stromverbrauch erforderlich ist.

Das Unternehmen wird eine „KI-System-Demo-Zone“ einrichten, in der Besucher erleben können, wie die für die Zukunft entwickelte KI-Systemspeicherlösung miteinander verbunden wird, um ein KI-Ökosystem zu bilden.

In dieser Zone wird das Unternehmen kundenspezifische cHBM vorstellen, die für einen bestimmten KI-Chip oder ein bestimmtes System optimiert sind, PIM -basiertes AiMX, CuD, das Berechnungen im Speicher durchführt, CMM-Ax, das Rechenkapazitäten in den CXL- Speicher integriert, und Data-aware CSD.

Für cHBM (Custom HBM) wurde aufgrund des besonderen Kundeninteresses ein großformatiges Modell entwickelt, um Besuchern die innovative Struktur anschaulich zu präsentieren. Da sich der Wettbewerb im KI-Markt von reiner Leistung hin zu Inferenzeffizienz und Kostenoptimierung verlagert, visualisiert dieses Modell einen neuen Designansatz, der einen Teil der Rechen- und Steuerungsfunktionen in HBM integriert, die bisher von herkömmlichen GPUs oder ASICs übernommen wurden.

„Da die durch KI angestoßenen Innovationen immer schneller voranschreiten, entwickeln sich die technischen Anforderungen unserer Kunden rasant weiter“, sagte Justin Kim , Präsident und Leiter der KI-Infrastruktur bei SK hynix. „Wir werden den Kundenbedürfnissen mit differenzierten Speicherlösungen gerecht werden. In enger Zusammenarbeit mit unseren Kunden wird das Unternehmen neue Werte schaffen und so zur Weiterentwicklung des KI-Ökosystems beitragen.“